这并非黄仁勋首次暗示英伟达正在超越“摩尔定律”■★。早在去年 11 月的一次播客节目中,黄仁勋就曾提出 AI 世界正以“超摩尔定律”的速度发展◆■。

黄仁勋声称他今天的 AI 芯片比 10 年前的产品好 1000 倍。这是一个比★★■“摩尔定律”设定的标准快得多的速度■■◆★◆★,黄仁勋表示他认为这种速度没有停止的迹象。

CES 2025 上,英伟达创始人兼 CEO 黄仁勋表示,“Windows 95 彻底改变了计算机行业■■■★◆,它使多媒体服务成为可能,对应用程序的开发方式影响深远★■★◆。然而★◆,这个计算模型对人工智能来说并不完美。我们的目标是,在未来,让人工智能成为你的助手。■■★■◆◆”

事实证明,实现这一目标的答案是 Windows WSL 2。WSL 2 将 Windows 和 Linux 无缝结合◆◆,运行效果出色★★◆◆◆,为开发者量身打造。你可以直接访问裸机资源,并且 WSL 2 已经针对云原生应用程序进行了优化,能够实现开箱即用的效果。只要你的计算机能够支持它■◆★◆★★,而你能够适应这种模式,我们就能提供多种适合的模型,无论是视觉模型、语言模型还是动画、数字人类或人类模型等各种类型的 AI 模型,都非常适合在你的电脑上运行。你可以轻松下载并使用它们。

1 月 8 日消息,在拉斯维加斯举行的国际消费电子展 (CES) 上◆★★,英伟达 CEO 黄仁勋在一次面向万人的主题演讲后接受 TechCrunch 采访时表示,其公司 AI 芯片的性能提升速度已远超数十年来推动计算机技术进步的★◆■★◆★“摩尔定律”设定的标准。

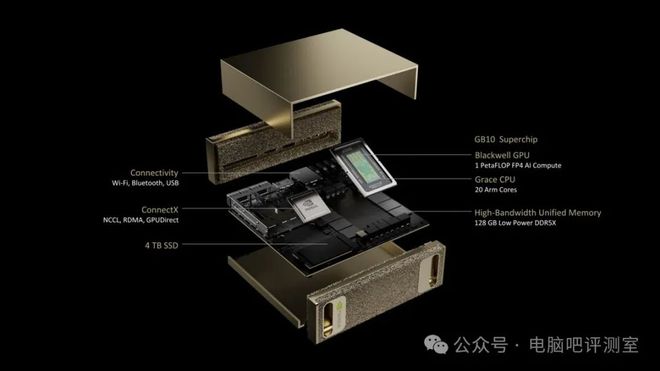

除了显卡外,NVIDIA在本次CES 2025上还宣布了Project DIGITS,NVIDIA称这是一款紧凑型超级计算机。在NVIDIA的阐述中■■,这款产品超越了对一般AI PC的定义■◆◆★■★,考虑到NVIDIA在AI硬件领域的优势,可能还真不是吹牛。另外,此前曾有过消息的NVIDIA与MTK首款合作芯片也在这款产品中亮相了,也就是为本产品赋能的NVIDIA GB10 Grace Blackwell Superchip芯片。从NVIDIA的描述来看◆★■,这款产品的应用场景更类似于开发机,将在5月份发布,不知道在个人领域有没有新的应用场景。

黄仁勋还驳斥了★■★★■“AI 进展放缓”的观点。他认为,当前 AI 领域存在三大扩展定律◆◆■◆■:预训练(pre-training)★★◆★、后训练(post-training)和推理时计算(test-time compute)■★◆■。预训练阶段★◆★,AI 模型从海量数据中学习模式;后训练阶段,通过人类反馈等方法微调模型■★◆;推理时计算则让模型在回答每个问题后有更多时间“思考”◆◆■■。黄仁勋强调■■◆◆,随着计算能力的提升,AI 推理成本将逐步降低,类似于摩尔定律推动计算成本下降的历史进程★■★■◆◆。

“我们可以同时构建架构◆★★◆■■、芯片★◆■■、系统、库和算法,”黄仁勋说◆★◆,“如果这样做★◆,我们就能比摩尔定律更快地发展,因为我们可以在整个技术栈中进行创新■★◆。”

用户可以在Project DIGITS上本地开发和测试AI模型◆★★,然后使用相同的Grace Blackwell架构和Nvidia AI Enterprise软件平台,能与云服务无缝集成◆◆,从而根据需要部署云加速模型。英伟达创始人兼首席执行官黄仁勋认为,AI时代已然到来,每个行业都有AI应用,虽然入门成本很高■◆,但是Project DIGITS标志着迈向更广泛可访问性的第一步。

目前,使用测试时计算的 AI 模型运行成本高昂。有人担心 OpenAI 的 o3 模型(使用了规模化的测试时计算)对大多数人来说过于昂贵■■◆。例如,OpenAI 使用 o3 在一项通用智能测试中达到人类水平的分数★■◆★◆,每项任务花费近 20 美元◆◆。而 ChatGPT Plus 的订阅费用为每月 20 美元。

新 闻 2: 黄仁勋:英伟达非常想把 AI 放在 PC 上◆■■◆,但 Windows 并不完美

据IT之家了解,“摩尔定律■■◆★◆★”由英特尔联合创始人戈登・摩尔于 1965 年提出■★■★,预测计算机芯片上的晶体管数量将大约每年翻一番■■■◆★★,从而使芯片性能也大致翻一番。这一预测基本实现了■★,并在几十年里推动了计算机性能的快速提升和成本的急剧下降。

近年来,“摩尔定律”的发展速度有所放缓。然而,黄仁勋声称,英伟达的 AI 芯片正以自身的加速节奏发展;该公司表示,其最新的数据中心超级芯片在运行 AI 推理工作负载方面的速度比上一代产品快 30 多倍■◆■◆★◆。

黄仁勋指出■◆◆■,◆■■★■“人工智能是在云端构建的,我们的愿景是将它带到任何地方,当然也可以在你的公司中进行部署★★◆★。英伟达最希望的是将其集成到个人电脑中。因此★■◆★◆,如果我们能找到一种方法,使 Windows PC 成为世界级的人工智能平台,那将是非常令人兴奋的★★■◆■。”

联发科 了Project DIGITS项目◆★■,与英伟达合作设计了NVIDIA GB10 Grace Blackwell Superchip芯片,主要负责CPU部分的设计。联发科副董事长暨首席执行官蔡力行表示■★:“我们与英伟达在GB10超级芯片上的合作★◆■★■★,与联发科希望把科技带给每个人的愿景不谋而合。我们期待与英伟达一起开启超级运算的创新时代,让AI无所不在★★■◆。”

最后,在演讲之后的采访中,黄仁勋还表达了■★◆“摩尔定律已死”的观点■■★◆■,当然老黄的观点是,自家芯片在AI性能上的迭代速度远超摩尔定律设定,不像某些进步不够快的厂商是认为进步速度跟不上◆◆■■。同时★★◆★■,黄仁勋还表达了对AI市场前景的乐观期望■★,不光不认为增速会放缓,还认为仍将继续加速增长,或许AI仍将在很长时间内成为各个行业的重要增长点。

英伟达 CEO 发表这一大胆言论之际,正值许多人质疑 AI 发展是否停滞之时。包括谷歌、OpenAI 和 Anthropic 在内的领先 AI 实验室都使用英伟达的 AI 芯片来训练和运行其 AI 模型★■■◆★,而这些芯片的进步可能会转化为 AI 模型能力的进一步提升。

“因此,我们的重点是将 Windows WSL 2 和 Windows PC 打造成理想的一流平台,并将在未来持续支持和维护这一平台。”黄仁勋表示。

在CES 2025上,英伟达 宣布 推出Project DIGITS,这是一款紧凑型超级计算机,类似于Mac Mini。Project DIGITS是英伟达第一台台式机产品,超出了AI PC的范畴,主要面向AI研究人员、数据专家、以及科学家等,起售价为3000美元(约合人民币21979.5元),最快5月上市■◆★★★■。

英伟达的 H100 芯片曾是科技公司训练 AI 模型的首选■★,但现在科技公司更加关注推理,一些人开始质疑英伟达昂贵的芯片是否还能保持领先地位。

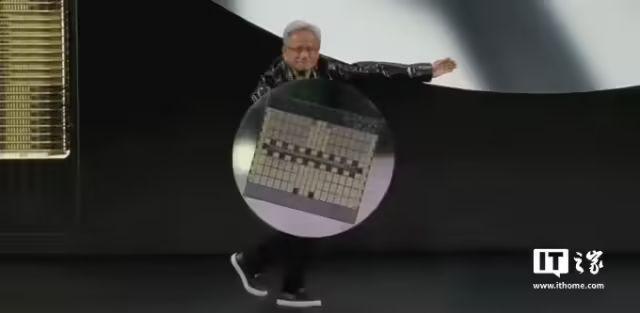

在周一的主题演讲中★★★,黄仁勋像举着盾牌一样展示了英伟达最新的数据中心超级芯片 GB200 NVL72。这款芯片在运行 AI 推理工作负载方面的速度比英伟达之前最畅销的芯片 H100 快 30 到 40 倍。黄仁勋表示★■◆◆■◆,这种性能的飞跃意味着像 OpenAI 的 o3 这样在推理阶段使用大量计算的 AI 推理模型,其成本将随着时间的推移而降低。

在过去一年里◆◆■,我们确实看到了 AI 模型的价格大幅下降,部分原因是英伟达等硬件公司的计算技术突破。黄仁勋表示■★,他预计这种趋势将随着 AI 推理模型的发展而继续下去◆■。

而在系统方面★◆■■,老黄则是直言不讳的表示,Windows在AI领域的表现◆★◆◆“并不完美”,但NVIDIA还是致力于改善Windows,使Windows PC 成为世界级的人工智能平台,最好的办法就是Windows WSL 2★◆■★■◆。不过这种操作本质上还是在用Linux或云服务来运行AI程序,或许Windows真的不那么适合AI吧……希望Windows也能有所变化◆◆★。

黄仁勋表示,他总体上专注于创造性能更强的芯片,而性能更强的芯片从长远来看会带来更低的价格。◆★■★★“无论是在性能还是成本承受能力方面,测试时计算的直接解决方案是提高我们的计算能力,”黄仁勋表示。他指出,从长远来看,AI 推理模型可以用于为 AI 模型的预训练和后训练创建更好的数据◆■■。

扫码关注

扫码关注

传真:86-010-57799518

邮箱:zgtdkj@163.com

地址:北京市丰台区丰体时代大厦C座